Episode 10.6 - Generate or delegate?

In der öffentlichen Debatte dominieren KI-Tools wie ChatGPT, Udio oder Midjourney, also überwiegend Tools, die zur Kategorie "Generative AI" (bzw GenAI) gehören und auf LLM (Large Language Model) basieren. Damit bezeichnet man KI-Modelle, die Inhalte erzeugen – Texte, Bilder, Code, Musik und mehr. Diese Systeme reagieren auf Eingaben, produzieren Ergebnisse und scheinen dabei beeindruckend kreativ zu sein. Aber: Sie handeln nicht selbstständig. Ohne eine direkte Anweisung, bzw. Prompt, bleibt ein generatives Modell passiv, ohne einen "Trigger" tun diese Dinger nichts. Ich habe in diesem Artikel schon die herausragendste Eigenschaft von LLMs hervorgehoben "Episode 10.2 - Fishing knowledge in a sea of words without drowning in it 🙂": Man kann damit endlich aus großen, unstrukturierten Datenmengen Informationen bzw. Wissen extrahieren.

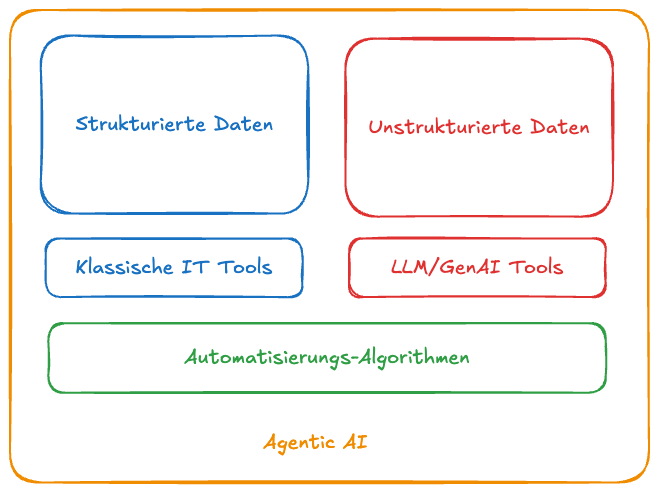

Wenn man diese LLMs mit klassischen IT-Tools, die mit strukturierten Daten arbeiten, kombiniert, entsteht eine neue Gattung an IT-Systemen, für die die Marketingleute das neue Buzzword "AgenticAI" kreiert haben. Durch diese Verbindung von klassischen IT-Systemen, die für strukturierte Daten optimiert sind (wie ERP, CRM oder Datenbanken), mit Large Language Models (LLMs), die unstrukturierte Daten wie Texte, E-Mails oder Dokumente interpretieren können, entsteht ein völlig neues Level an Automatisierungsmöglichkeiten. Diese Integration ermöglicht es, Daten aus unterschiedlichsten Quellen zu kombinieren, Zusammenhänge zu erkennen und automatisiert Maßnahmen einzuleiten – etwa indem ein AgenticAI-System eine Rechnung analysiert, die relevanten Daten mit einem LLM extrahiert, mit Bestellungen aus dem ERP abgleicht und bei Bedarf automatisch eine Rückfrage per Email oder eine Korrektur einleitet.

AgenticAI = GenAI + Automatisierung

Im Gegensatz zur GenAI können AgenticAI Systeme nicht nur Inhalte erzeugen, sondern eigenständig Ziele verfolgen, Aktionen planen und auf Umweltveränderungen reagieren können. Die Automatisierungs-Algorithmen kombinieren verschiedene Fähigkeiten (z. B. Recherche, Entscheidungsfindung, Ausführung) und Informationsquellen, und können so komplexe Aufgaben proaktiv lösen.

AgenticAI Systeme sind sehr mächtige IT-Systeme

- Autonome Entscheidungsfindung: Sie können (bzw. ihre Algorithmen) eigenständig Entscheidungen treffen, ohne dass jeder Schritt vorher festgelegt werden muss. Sie nutzen LLMs, um natürliche Sprache zu verstehen, um aus großen Datenmengen die passenden Informationen zu extrahieren und daraus Handlungen abzuleiten.

- Mehrstufige Aufgabenbearbeitung: Sie können komplexe Aufgaben in kleinere Schritte aufteilen, planen deren Ausführung und führen sie aus – ähnlich wie ein menschlicher Agent, der ein Ziel verfolgt und dabei flexibel auf Veränderungen reagiert.

- Nutzung von Tools und Systemen: AgenticAI ist „Tool-Aware“ – sie weiß, welche internen und externen Systeme sie nutzen kann, und steuert diese automatisiert an, um Aufgaben wie Datenbankabfragen, Dokumentenanalyse oder Geschäftsprozesse auszuführen.

- Lernen und Anpassung: Diese Systeme sammeln Feedback und Erfahrungen, um sich kontinuierlich zu verbessern. Sie können ihre Strategien und Modelle anpassen, um in dynamischen, unvorhersehbaren Umgebungen effektiver zu arbeiten. Sie können sogar autonom die Algorithmen anpassen.

Mensch-Maschine? Fast: wir kommen dem ein Schritt näher*

Mit AgenticAI werden komplexe Geschäftsprozesse automatisierbar, die bisher zu schwierig waren für klassische Automatisierungslösungen, weil man für das Bearbeiten von unstrukturierten Daten Menschen brauchte. Verträge lesen, E-Mails bearbeiten, an Meetings teilnehmen, Berichte erstellen, etc ... das sind alles Prozesse des "Knowledge Workers" den Peter Drucker beschrieben hat, die man jetzt mit LLMs optimieren kann. Und das beträchtlich: wo ein Mensch Stunden bräuchte, um einen 100-seitigen Text zusammenzufassen, kann ein LLM das in Sekunden erledigen. Es kann in wenigen Minuten die Aufzeichnung eines mehrstündigen Meetings transkribieren und verteilen. Oder hunderte von Bewerbungsschreiben viel schneller klassifizieren als jeder Sachbearbeiter. Genau darin liegt das Potenzial zur Zeiteinsparung.

AgenticAI - Immens vielversprechend, aber es ist, wie immer, einfacher gesagt als getan

Die wichtigsten Vorteile einer "AgenticAI Experience" für Organisationen sind typische "Digital Transformation" Vorteile (ich erspare ihnen daher zu viel des üblichen Marketinggeschwurbel):

- Gesteigerte Effizienz und Produktivität: Man automatisiert Routineaufgaben und komplexe Workflows, reduziert manuellen Aufwand und beschleunigt Prozesse. Mitarbeitende können sich auf wertschöpfende, strategische Aufgaben konzentrieren, während die KI repetitive und zeitaufwändige Tätigkeiten übernimmt.

- Bessere Entscheidungsfindung und Agilität: Dank Echtzeit-Analyse großer Datenmengen und kontinuierlichem Lernen liefert Agentic AI fundierte, datenbasierte Entscheidungsgrundlagen und beschleunigt so die Reaktionsfähigkeit des Unternehmens.

- Innovativere Geschäftsmodelle: Agentic AI ermöglicht neue, automatisierte Dienstleistungen und eröffnet Unternehmen völlig neue Wertschöpfungspotenziale.

Die Nutzung von AgenticAI in Unternehmen bringt aber auch eine Reihe ethischer Herausforderungen mit sich, die sorgfältig adressiert werden müssen (Hier erspare ich ihnen zu viele Bedenkenträger-Argumente) :

- Transparenz und Nachvollziehbarkeit: Die Entscheidungen von AgenticAI-Systemen müssen nachvollziehbar und erklärbar bleiben. Man muss sicherstellen, dass die Logik und die Gründe für Entscheidungen transparent sind und nicht einer „Black Box“ überlassen werden.

- Verantwortung und Haftung: Mit zunehmender Autonomie stellt sich die Frage, wer für Fehlentscheidungen oder Schäden verantwortlich ist – das Unternehmen, die Entwickler oder der Nutzer. Klare Governance-Strukturen und Verantwortlichkeitsketten sind notwendig, um Haftungsfragen zu klären.

- Algorithmische Bias und Halluzinationen: LLMs können Verzerrungen (Bias) aus den Trainingsdaten übernehmen und falsche Informationen erzeugen (Halluzination). Regelmäßige Audits, vielfältige Datenquellen und transparente Modelle sind notwendig, um das zu entdecken und korrigieren.

- Autonomie ist gut, Kontrolle ist besser: Auch bei hoher Autonomie bleibt die menschliche Kontrolle wichtig, insbesondere bei kritischen Entscheidungen. Unternehmen sollten klare Eskalationspunkte und Kontrollmechanismen definieren, um ungewollte oder schädliche Aktionen zu verhindern.

Diese Punkte machen deutlich, dass AgenticAI nicht nur technisch, sondern auch ethisch, rechtlich und gesellschaftlich verantwortungsvoll gestaltet werden muss, um nachhaltigen Nutzen zu stiften und Risiken zu minimieren.

Ein paar Empfehlungen auf dem Weg zur "AgenticAI Experience"

Ich kann nur empfehlen, schnellstmöglich die Einführung von AgenticAI zu evaluieren und Roadmaps für deren Umsetzung zu erstellen. Das Potenzial ist wie gesagt immens und wettbewerbsentscheidend. Aus meiner Sicht fängt es damit an, mit einer prototypischen Infrastruktur zu experimentieren und eigene Proof-Of-Concept-Projekte anzusetzen (POCs), aber dabei unbedingt folgende Vorsichtsmaßnahmen beachten:

Vorsicht mit eigenen Daten und fremden LLMs!

Bevor man loslegt und wild automatisiert, muss man sich einer Sache bewusst sein: Wenn man externe LLMs nutzt, gibt man seine Daten her. Die Sicherheit der eigenen Daten und Infrastruktur ist stark gefährdet und das muss sorgfältig abgewogen werden. Grundsätzlich empfehle ich da die Einrichtung einer lokalen LLM Infrastruktur, um AgenticAI Projekte aufzusetzen und zu testen, ohne Daten in die Cloud senden zu müssen. Von externen Lösungen wie Copilot etc. kann ich derzeit nur dringend abraten.

LLMs müssen maßgeschneidert werden, um weniger zu halluzinieren

Die gängigen LLMs, die es auch als Open-Source gibt und daher in einer geschützten und eigenen Infrastruktur betrieben werden können, wurden mit allgemeinen und öffentlich zugänglichen Daten gefüttert und für allgemeine Aufgaben trainiert. Um sie für eigene Prozesse einzusetzen, müssen diese mit dem eigenen Wissen ergänzt werden und für den unternehmerischen Kontext feingetunt werden. Nur so kann man die Ergebnisqualität kontrollieren und verbessern.

"It's the process, stupid!"

Wie bei jeder "Digitale Transformation" steht die Optimierung von Prozessen im Vordergrund. In diesem Fall geht es spezifisch um die "Knowledge Worker Prozesse". Man muss diese erstmal klar beschreiben können, bevor man sie optimieren kann. Doch gerade diese sind nicht unbedingt klar dokumentiert, da sie oft auf informelle und unstrukturierte Weise ablaufen, über Meetings, Emailaustausch, Telefongespräche, Chats, Präsentationen, etc (Genau, es geht ja um unstrukturierte Daten). Um diese zu erfassen und darstellen zu können, helfen Analysetools wie zB die OOM-Scorecard. Wenn diese Prozesse nicht einigermaßen gut bekannt sind, stochert man im Dunkeln.

👀 Lesenswert: Der Aufstieg der Nerds

⭐️ Favorit der Woche: t3.chat Dieses Tool ist ideal für alle, die mit verschiedenen LLMs experimentieren, arbeiten und/oder deren Vor- und Nachteile evaluieren möchten. T3 Chat ist ultraschnell und ermöglicht den direkten Wechsel zwischen mehreren führenden KI-Modellen, um sie gegeneinander konkurrieren zu lassen. Mit einem klaren Interface und einer günstigen Preisstruktur ist es einer meiner wichtigsten Begleiter auf diesem KI-Trip geworden.

Live long and prosper 😉🖖

*Muzicbezug 🎧 (ja, schon wieder, es passt zu gut 😉)