Episode 11.0 - Auf dem Weg zur eigenen Intelligenz-Infrastruktur

Reminder: AI is not a product, it's a feature. Entscheidend ist also nicht das isolierte KI-Produkt, sondern die durchdachte Integration fortschrittlicher KI-Funktionen in die eigenen Unternehmensabläufe. Nur so wird aus KI ein nachhaltiger und messbarer Wettbewerbsvorteil. Insbesondere vor dem Hintergrund steigender regulatorischer Anforderungen und wachsender Datenschutzbedenken rückt die Frage nach eigener, kontrollierbarer KI-Infrastruktur immer mehr in den Mittelpunkt. Open-Source-Lösungen spielen dabei eine Schlüsselrolle – sie ermöglichen maßgeschneiderte, rechtskonforme und datensichere Innovation fernab kurzfristiger Hypes.

Es gibt nicht die eine perfekte KI

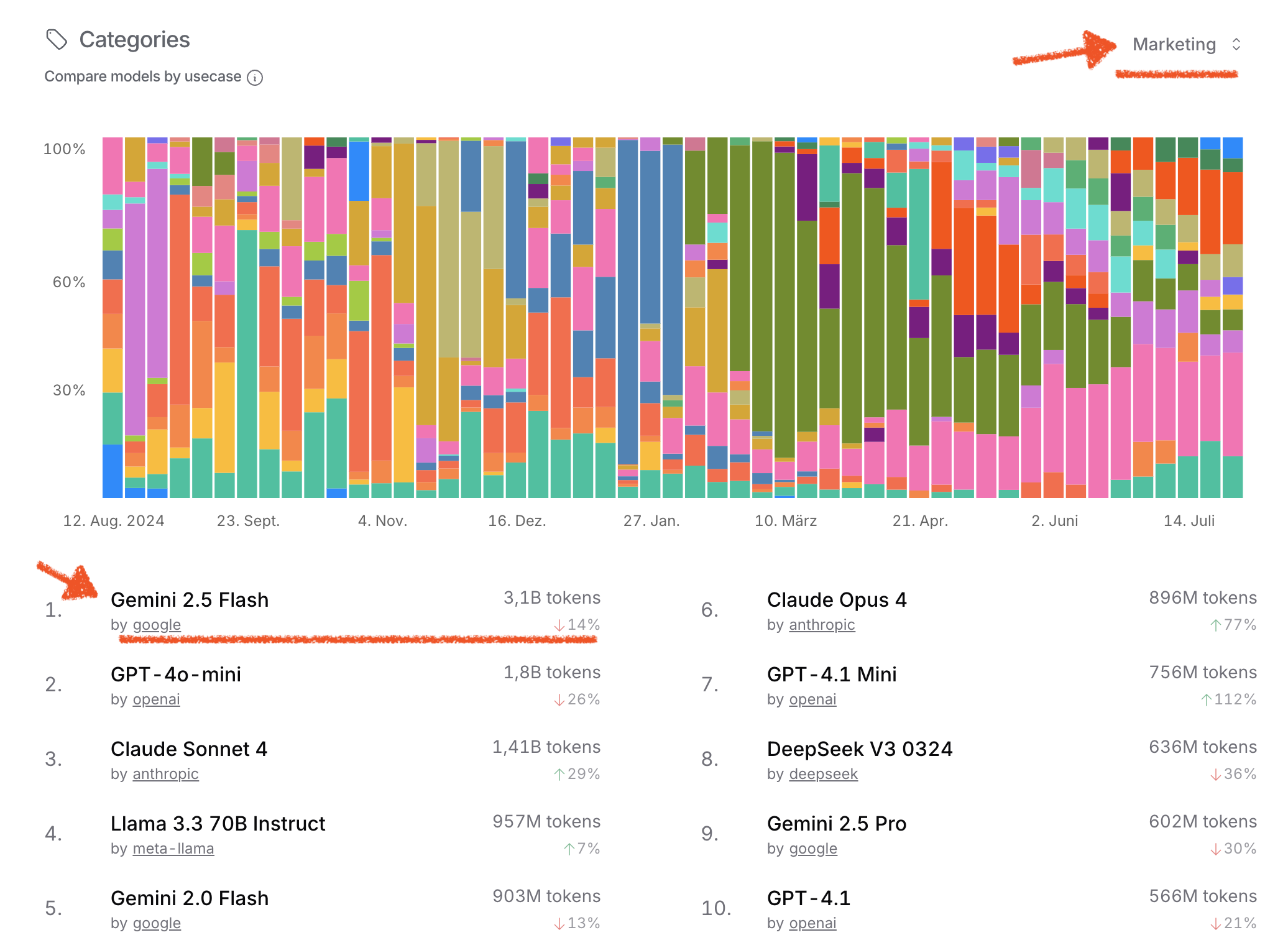

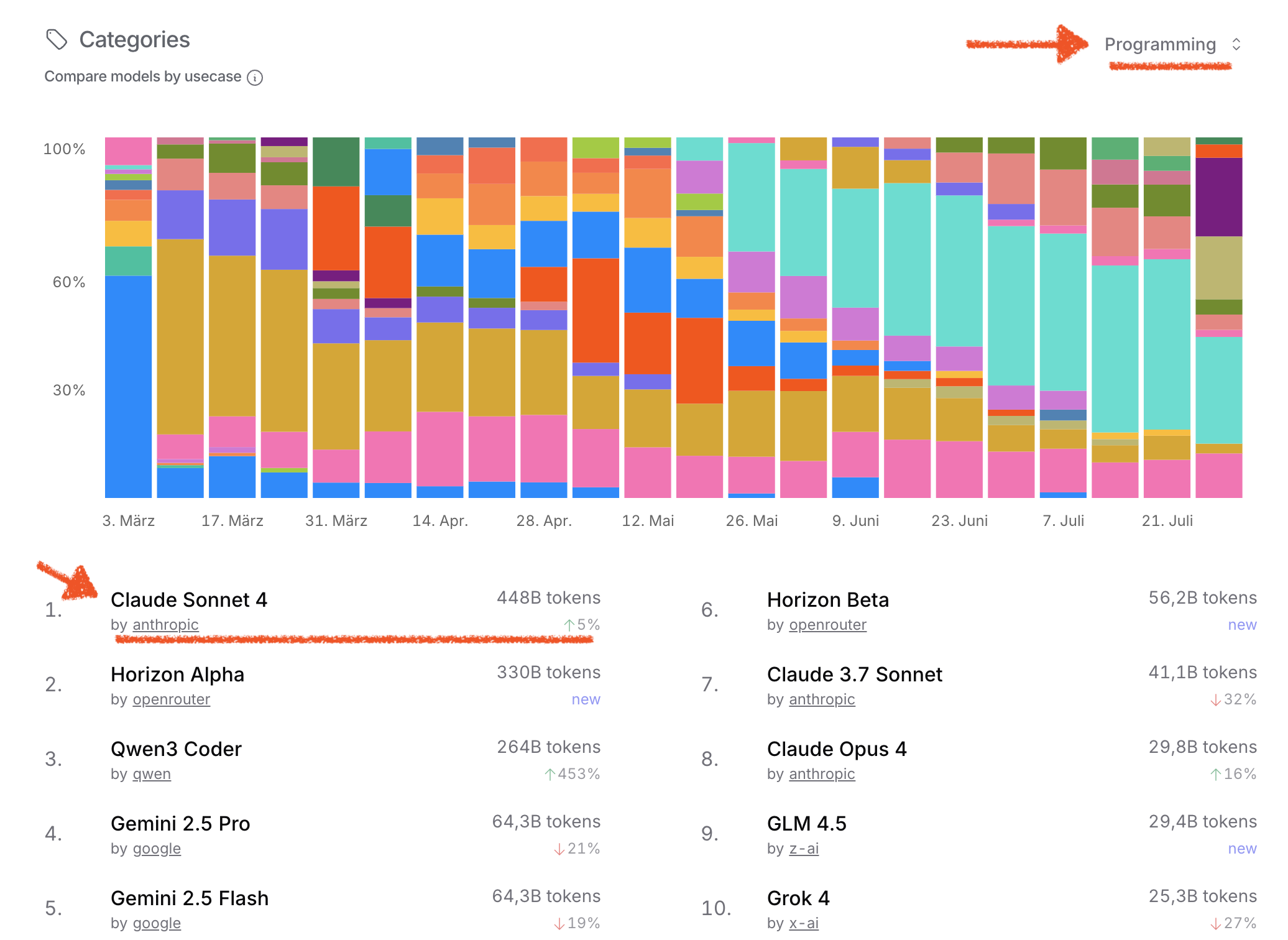

Ein weit verbreiteter Irrglaube ist, dass es „die beste KI“ gibt, die alle Aufgaben gleichermaßen gut löst. In der Realität ist Künstliche Intelligenz hochgradig spezialisiert: Ein Modell, das exzellent im Schreiben von Texten ist, kann bei technischen Anfragen versagen. Ein anderes, das präzise Programmcode generiert, liefert möglicherweise schlechte Antworten bei kreativen Aufgaben.

Diese Unterschiede liegen an:

- Architektur und Training (z. B. auf welche Daten ein Modell trainiert wurde)

- Optimierungsschwerpunkten (z. B. für Dialog, Code, Bilderkennung, Zusammenfassungen)

- Rechenanforderungen und Geschwindigkeit

Deshalb ist es entscheidend, das passende Modell für den jeweiligen Anwendungsfall zu wählen.

Gerade weil es nicht diese eine universelle KI gibt, sondern unterschiedliche Modelle mit jeweils spezifischen Stärken, ist es umso wichtiger, als Unternehmen Zugriff auf eine breite Auswahl, volle Transparenz und Anpassbarkeit zu haben. Auch hier bieten Open-Source-KIs einen entscheidenden strategischen Vorteil: Sie ermöglichen nicht nur den Zugang zu modernsten Modellen, sondern auch deren individuelle Optimierung – abgestimmt auf Ihre Anforderungen, Ihre Daten und Ihre Infrastruktur.

Ein zentraler Akteur dieser Bewegung ist zum Beispiel Hugging Face – eine der weltweit führenden Plattformen für Open-Source-KI.

Was ist Hugging Face?

Hugging Face ist eine offene Plattform samt Community, die den Zugang zu modernster KI-Technologie demokratisiert und Kollaboration in den Mittelpunkt stellt. Die Plattform bietet:

- Zugang zu über 1,7 Millionen frei verfügbaren KI-Modellen (NLP, Vision, Audio, Multimodal, u.v.m.), darunter aktuelle Modelle wie Deepseek, Kimi K2, Qwen 3 etc.

- Öffentliche und private Repositories für Modelle, Datasets, Workflows und Pipelines

- Evaluierungs- und Deployment-Tools plus umfangreiche Demos

- Eine weltweite Community von Unternehmen, Forschungseinrichtungen und Developern

Warum ist Open Source relevant für den Unternehmenseinsatz von KI/LLMs?

Aufgrund von Regulierung, aber auch schlicht durch gesunden Menschenverstand beim Dekodieren der aktuellen Hype-Wellen, ist der Ansatz KI inhouse aufzubauen, derzeit der richtige Weg.

1. Volle Kontrolle und Sicherheit

- Modelle können On-Premises, in der Private Cloud oder lokal betrieben werden: maximale Kontrolle über alle sensiblen Daten

- Compliance & Governance: DSGVO, KI Act, branchenspezifische und interne Richtlinien lassen sich erfüllen

- Unabhängigkeit von API-Kosten, Serviceverfügbarkeit und externen Anbietern.

2. Wirtschaftlichkeit & ROI

- Wegfall von Lizenzkosten und Vendor-Lock-in – Investitionen fließen direkt in eigene Wertschöpfung

- Schnelle Produktentwicklung dank sofort einsatzbereiter Modelle – ideal für Prototyping, Automatisierung und Go-to-Market.

- Hinweis aus Marktstudien: Über 50% der Unternehmen erzielen mit Open-Source-KI schneller einen positiven ROI als mit Closed-Source-Alternativen

3. Maximale Anpassungsfähigkeit

- Flexible Integration in eigene Geschäftsprozesse – von der Wissensdatenbank bis zum kundenbezogenen Support und effizientem Change Management.

- Modelle lassen sich effizient für spezifische Fachdomänen und Anwendungsfälle feinjustieren (Transfer Learning)

Für schnelles Testen & Vergleichen: Groq & OpenRouter

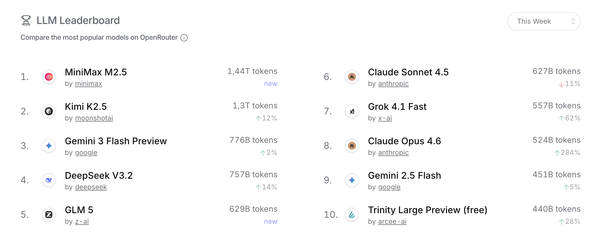

Bevor man eigene Modelle angeht und um die bei KI notwendige Lernkurve zu erklimmen, lohnt es sich vorher alle möglichen Modelle, ob Open Source oder proprietär, auszuprobieren. Für die Evaluierung und Auswahl des optimalen Modells bieten spezialisierte Plattformen wie Groq und OpenRouter entscheidende Vorteile:

- Vergleich unterschiedlichster KI-Modelle (Hugging Face, Meta, Mistral, Google, OpenAI etc.) in Echtzeit – ohne lokale Infrastrukturinvestition

- Schnelle und kostenkontrollierte Tests bezüglich Rechenleistung, Qualität und Geschwindigkeit von LLMs – ideal zur Entscheidungsfindung vor Rollout

- Zugriff auf High-Performance-Hardware und APIs, die sich leicht in bestehende Workflows einbinden lassen.

- Keine langfristige Bindung – maximale Agilität in der Pilotierungs- oder POC-phase.

Nicht vergessen: sobald man externe LLMs nutzt, verliert man die Datenhoheit, unüberlegtes copy/paste kann schnell zu Desaster führen. Wer erstmal im Kleinen experimentieren möchte -> Tool Quick Dive: t3.chat - Das Schweizer Messer für's Prompten*

Hardware für Open-Source-KI im Unternehmen

Hier kann und sollte man auch iterativ vorgehen, erst lernen und POC-Projekte aufsetzen und wenn man das Thema beherrscht zur Skalierung übergehen, um es unternehmensweit zu deployen.

Dank der breiten Auswahl an Modelle, Frameworks und leistungsfähiger Hardware ist der Einstieg heute viel niederschwelliger als früher:

- Viele produktive Anwendungsfälle laufen performant auf Workstations mit Multi-Core-CPUs und modernen GPUs – auch Feintuning ist lokal oder in der Cloud möglich

- Ein leistungsstarkes und wirtschaftliches POC- und Test-Setup: Apple Mac Studio (mit M3 Ultra, bis 512 GB RAM) – dank Unified Memory & nativer KI-Integration bestens für Entwicklung und Inferenz mittlerer Modelle geeignet.

- Wichtig sind hier starke GPUs mit viel RAM und hoher Bandbreite beim Speicherzugriff (daher ist der Mac Studio interessant)

Für sehr große Modelle/Training: Dedizierte GPU-Server (NVIDIA A100/H100) oder skalierbare Cloud-Lösungen (AWS, Azure, GCP, Hugging Face Hub) bleiben die erste Wahl für maximale Skalierung.

Fazit: just do it 😉

Abschließend lässt sich festhalten: Wer Künstliche Intelligenz als strategischen Hebel nutzen und dabei regulatorische sowie unternehmensspezifische Anforderungen erfüllen will, kommt an selbstbestimmter Integration und Open-Source-KI kaum vorbei.

Nicht das bloße Kaufen von fertigen KI-Produkten, sondern die gezielte Einbettung leistungsfähiger, anpassbarer Modelle als „Feature“ in bestehende Prozesse eröffnet Unternehmen nachhaltige Mehrwerte – von verbesserter Datensouveränität bis hin zu beschleunigter Innovation. Die Kombination aus eigener Infrastruktur, offenen Ökosystemen und konsequenter Prozessoptimierung ist der Schlüssel, um den vollen Nutzen der KI-Transformation auszuschöpfen.

👀 Lesenswert:

- Clash of the Titans: Why Open Source AI Is Winning With Businesses – Big and Small

- McKinsey: Open source technology in the age of AI

- IBM: What is Hugging Face?

Live long and prosper 😉🖖

Off Topic, aber nicht wirklich: falls sich jemand für Typografie interessiert, Harald Geisler hat sich die Mühe gemacht, die Schreibschrift von Albert Einstein als Computerfont zu erfassen. Und nachdem die heutige Zeit auch psychisch immer belastender wird, hat er das auch für die Schreibschrift von Sigmund Freud gemacht - Diese Schriften nutze ich gerne, wenn ich nichts Schlaues zu sagen habe (sprich meistens), es aber trotzdem schlau ausschauen soll 😀