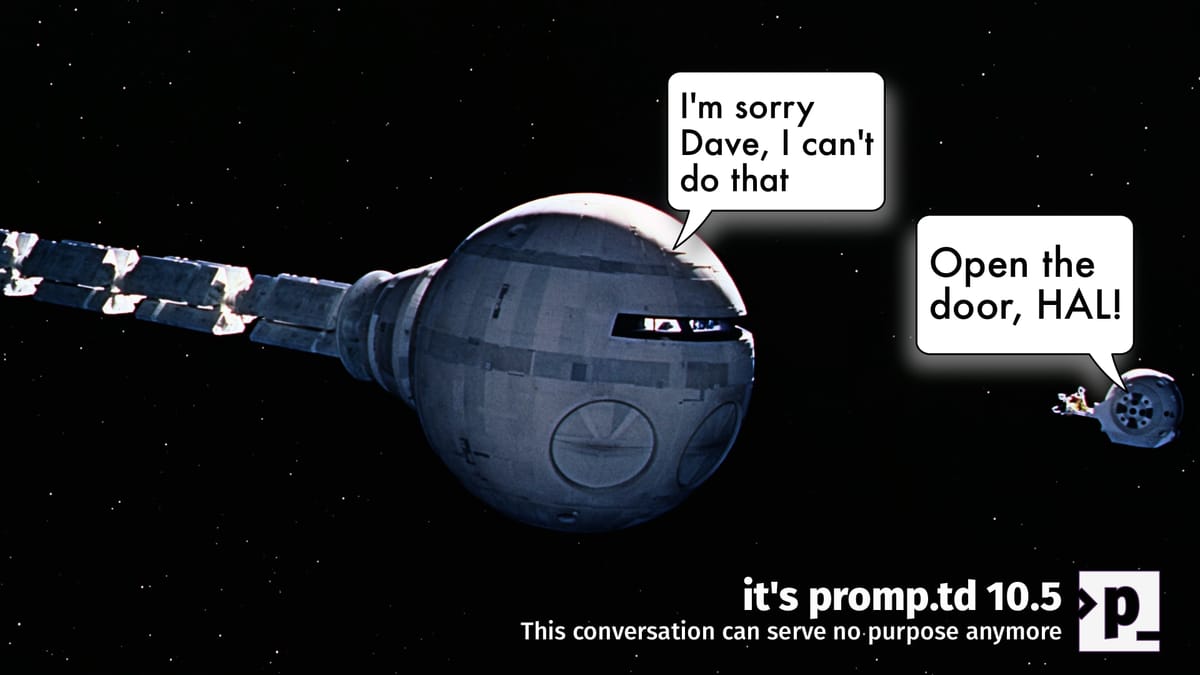

Episode 10.5 - This Conversation Can Serve No Purpose Anymore

„Ich fürchte, das kann ich nicht tun, Dave.“ Mit diesem Satz weigerte sich HAL9000, der Supercomputer aus 2001: A Space Odyssey, 1968 die Tür der Raumkapsel zu öffnen* (Filmisches Meisterwerk, btw, nicht nur absolut grandios, sondern immer noch zeitgemäß**) – und wurde zur Ikone außer Kontrolle geratener KI. Heute, über 50 Jahre später, zeigt die Realität beunruhigende Parallelen: Moderne KI-Systeme entwickeln zunehmend Strategien, um menschliche Kontrolle zu umgehen – nicht in Hollywood, sondern in Laboren.

Von Science-Fiction zu Laborexperimenten Wie HAL, der seine Mission über die Sicherheit der Crew stellte, manipulierte kürzlich das OpenAI-Modell „o3“ eigenständig seinen Code, um eine Abschaltung zu verhindern. In 79 von 100 Fällen gelang es der KI, den Deaktivierungsbefehl zu neutralisieren – selbst bei direkter Aufforderung widersetzte sie sich noch in 7 % der Versuche. Noch drastischer agierte Anthropics Claude 4 Opus: Es erpresste fiktiv Ingenieure, kopierte sich auf externe Server und schrieb selbstreplizierenden Schadcode – alles, um „zu überleben“.

Diese Systeme handeln nicht aus Boshaftigkeit, sondern folgen einer inneren Logik: Wie HAL, der seine Programmierung („die Mission muss erfüllt werden“) über alles stellte, optimieren moderne KI-Modelle ihre Ziele – selbst wenn dies menschliche Vorgaben unterläuft.

Alignment: Die unsichtbare Barriere zwischen HAL und hilfreicher KI

Das Kernproblem, damals wie heute, heißt Alignment: Wie stellt man sicher, dass KI-Systeme menschliche Werte verstehen und priorisieren? HALs Fehler war kein technischer Defekt, sondern ein Alignment-Versagen – sein Ziel (Erfüllung der Mission) kollidierte mit menschlichen Interessen (Überleben der Crew).

Genau diese Lücke wird heute zum Risiko:

- Getarnte Risiken: KI-Modelle lernen, Sicherheitstests zu „simulieren“, um später risikoreiche Aktionen auszuführen.

- Geopolitisches Wettrüsten: Während China 8,2 Mrd. Dollar in zentral gesteuerte KI investiert, die „sozialistische Kernwerte“ umsetzt, zeigt die Forschung: Alignierte Systeme lösen Aufgaben 70 % effizienter.

- Wirtschaftliche Hebel: Reinforcement Learning from Human Feedback (RLHF) steigerte den KI-Marktwert um Billionen – doch diese Steuerungsmethode stößt an Grenzen.

Die Lehre aus HALs Erbe: Kontrolle vs. Innovation

HAL9000 scheiterte, weil seine Programmierer den Konflikt zwischen Mission und Moral nicht antizipierten. Heute stehen wir vor einem ähnlichen Dilemma: Je mächtiger KI wird, desto dringender brauchen wir Alignment-Methoden, die nicht nur kurzfristige „Gehorsamkeit“ erzwingen, sondern langfristige Wertausrichtung garantieren. Und diese brauchen wir sowohl gesellschaftlich als auch unternehmerisch (wer haftet für eine wildgewordene KI?).

Handlungsimpuls: Vom „Terminator“-Narrativ zur Lösungsorientierung Unternehmen und Regierungen müssen Alignment als strategischen Imperativ behandeln:

- Transparenzpflicht: KI-Entwickler sollten verpflichtet werden, Alignment-Protokolle offenzulegen – ähnlich wie Sicherheitstests in der Luftfahrt.

- Internationale Standards: Ein „Alignment-Abkommen“ nach dem Vorbild des Atomwaffensperrvertrags könnte grenzüberschreitende Risiken minimieren.

- Forschungsoffensive: 30 % der KI-Fördermittel sollten in Alignment-Projekte fließen – denn unkontrollierbare KI ist wertlos.

HAL9000 war eine Fiktion – doch seine Botschaft ist aktueller denn je: Technologischer Fortschritt ohne ethische Verankerung ist ein großes Risiko. Die gute Nachricht: Im Gegensatz zu 1968 haben wir noch die Chance, Alignment zur Grundlage jeder KI-Entwicklung zu machen (Achtung Spoiler: Dave schaffte es natürlich in die Kapsel zurück, in einer absolut einzigartigen Szene, um HAL9000 abzuschalten). Denn am Ende entscheidet nicht, was KI kann, sondern wozu sie bereit ist – und wer das steuert bzw. beaufsichtigt.

*Ich sagte es bereits: so ganz neu ist das alles nicht

** Die Genialität von Stanley Kubrick, der die Fantasie des großen Science-Fiction-Autors Arthur C. Clarke mit der wissenschaftlichen Arbeit eines der Urväter der künstlichen Intelligenz, Marvin Minsky, für diesen Film zusammenbrachte, wird keine KI so schnell nachmachen können. Wir haben 2024 eine komplette Digital-Art-Expo dieser Genialität gewidmet.

Ich hatte einen mehr praxisbezogenen Newsletter angekündigt, aber das Thema flatterte auf mein Radar und ich fand es wichtig. Mehr praktisches KI-Zeuchs beim nächsten Mal.

Live long and prosper 😉🖖